文 | 付一强、曹建峰

各国政府(比如美国、英国等)以及一些社会公共机构(比如UN、IEEE等)也开始积极关注人工智能的法律、伦理、社会、经济等影响,密集出台战略文件和报告。借鉴发达国家和国际社会已有经验和案例,对中国企业预判后续可能面临的前瞻性法律政策问题有所裨益。

人工智能应用中面临的法律政策问题

1、图像识别领域

图像识别领域面临的用户隐私保护和种族歧视等问题突出。

一方面,图像识别软件的不包容和歧视的问题已经出现,比如,谷歌的图片软件曾错将黑人的照片标记为“大猩猩”, Flickr的自动标记系统亦曾错将黑人的照片标记为“猿猴”或者“动物”。

另一方面,社交媒体的图片标签或者自动标记功能可能引发关于用户隐私的争议,比如,Facebook的图片标记功能利用人脸识别技术就图片中的人像向用户进行“标签推荐”,这被认为是在未获用户明确同意的情况下收集用户的“脸纹”等生物识别信息,违反了美国伊利诺伊州的《生物识别信息隐私法》,而被用户提起隐私侵权诉讼,谷歌等企业的类似技术也引发了类似诉讼。因此,在欧盟、加拿大等地区,Facebook不得不暂停这项技术。

2、语音识别领域

语音识别领域也已经出现性别和种族歧视、伦理以及声音权保护等问题。基于自然语言处理的语音识别正在快速发展,如亚马逊的Alexa、苹果的Siri、微软的Cortana等。但这一领域却被诟病为已经产生了严重的性别歧视问题。

比如,2016年3月23日,微软公司的人工智能聊天机器人Tay上线。出乎意料的是,Tay一开始和网民聊天,就被“教坏”了,成为了一个集反犹太人、性别歧视、种族歧视等于一身的“不良少女”。于是,上线不到一天,Tay就被微软紧急下线了。类似的伦理问题已经引起诸多关注,批判硅谷正在将人类社会既有的种族歧视、性别歧视等问题带入机器学习的声音逐渐增多。

同时,在模拟人声方面,也出现声音是否受法律保护以及怎样保护的问题。比如,已经出现使用名人声音进行人工智能语音训练从而实现智能模仿他人声音效果的业务形态。

在国内,对于这种所谓的“声音权”并无明文规定,相关学者认为可以通过设立肖像声音权、声音语言权、形象权、独立声音权等方面进行保护,但尚未达成一致。在国外,对声音进行明确法律保护的国家或地区也较少,比如,澳门、捷克斯洛伐克和美国加利福尼亚州等为数不多的国家或地区,美国也有将其作为商品化权进行保护的观点,相关的立法动态后续还需要继续保持关注。

3、广告投放领域

广告投放领域面临的问题主要集中在用户数据的收集和使用、算法歧视等方面。算法歧视早已引起人们关注,在互联网广告领域同样存在这一问题。

比如,研究表明,在谷歌搜索中,相比搜索白人的名字,搜索黑人的名字更容易出现暗示具有犯罪历史的广告。再比如,在谷歌的广告服务中,男性比女性看到更多高薪招聘广告,当然,这可能和在线广告市场中固有的歧视问题有关,广告主可能更希望将特定广告投放给特定人群。

此外,基于用户自动画像和自动化决策的的精准广告投放正日益流行(自动化决策在信贷、保险等领域的应用也在加强),其中涉及用户数据的收集使用、对用户保持透明以及歧视等问题。

各国对人工智能法律政策问题的探索

1、在知识产权方面

人工智能中新产生作品的权利归属问题较为突出。欧盟法律事务委员会建议欧盟委员会就与软硬件标准、代码有关的知识产权提出一个更平衡的路径,以便在保护创新的同时,也促进创新。同时,对于计算机或者机器人创作的可版权作品,需要提出界定人工智能的“独立智力创造”的标准,以便可以明确版权归属。

此外,国际标准化组织IEEE在其标准文件草案《合伦理设计:利用人工智能和自主系统(AI/AS)最大化人类福祉的愿景》中也提出,应对知识产权领域的法规进行审查,以便明确是否需对AI参与创作的作品的保护作出修订,其中基本原则应为,如果AI依靠人类的交互而实现新内容或者发明创造,那么使用AI的人应作为作者或发明者,受到与未借助AI进行的创作和发明相同的知识产权保护。

2、在隐私和数据保护方面

在人工智能领域,欧盟认为除了应该按照必要性原则和比例原则等保护隐私和数据之外,还应该有更多的标准、规范。

欧盟法律事务委员会建议,在针对人工智能和机器人制定政策时,应当进一步完善通过设计保护隐私(privacy by design)、默认保护隐私(privacy by default)、知情同意、加密等概念的标准。当个人数据成为“流通物”使用时,在任何情况下都不得规避涉及隐私和数据保护的基本原则。

其实,在2016年通过的《一般数据保护条例》(简称GDPR)中,欧盟就加强了个人隐私和数据保护,其中关于用户画像等自动化决策的规定将对基于大数据的互联网行业实践产生重大影响,即用户有权拒绝企业对其进行画像等自动化决策,而且用于用户画像的数据不能包括人种或者种族起源、政治意见、宗教或者哲学信仰、商会会员、基因、生物特征、健康状况、性生活等特殊类别的个人数据。这将对个性化服务的提供产生重大影响。

3、在标准化建设方面

国际社会将推进标准化工作作为人工智能发展的重要抓手。

欧盟法律事务委员会建议欧盟委员会应继续致力于技术标准的国际统一,欧盟层面,需要建立相应的标准化框架,以免造成欧盟各成员国之间标准的不统一以及欧盟内部市场的分裂。

此外,IEEE于去年年底出台的指南文件中也呼吁各方形成一系列标准,用于指导人工智能研发和应用。

美国在去年出台的涉及人工智能、自动驾驶等的多份报告和政策如《联邦自动驾驶汽车政策》、《美国国家人工智能研发战略计划》、《为人工智能的未来做好准备》等中,也要求加强并统一技术、数据使用、安全等标准建设,避免造成碎片化的问题,影响人工智能研发和应用。

4、其他法律政策方面

(1)算法决策公开透明化

实现算法决策的透明性和公平性是国际社会的一个主流关注点。基于机器学习的自主或者自动化的决策系统日益被广泛应用在推荐引擎、精准广告、信贷、保险等诸多领域,甚至政府部门也利用自动化决策来处理给犯罪人定罪量刑等公共事务,然而算法模型的设计都是编程人员的主观选择和判断,所使用的数据也可能是不相关和不准确的,这就可能导致自动化决策的结果影响个人权益,或者对某些群体造成歧视。

确保算法及其决策可以有效接受中立第三方或者监管机构的审查,实现算法决策的透明性和公平性,是国际社会的一个主流关注点。IEEE提出,应当为个人提供异议和救济的渠道。欧盟的GDPR则赋予个人反对自动化决策的权利,意味着算法决策需要透明化。

(2)防止歧视和偏见

国际社会日益重视在人工智能领域对数据的收集和分析进行规范,以防止歧视或偏见。

美国联邦贸易委员会(FTC)在2016年1月发布的《大数据:包容性工具抑或排斥性工具?》(Big data: a Tool for Inclusion or Exclusion?)特别关注大数据中的歧视和偏见问题,对于消费者,一方面需要确保公平机会法律得到有效执行,另一方面防止大数据分析中采取歧视等不公平行为;对于企业,FTC建议企业考察以下问题:数据集是否具有代表性,所使用的数据模型是否会导致偏见,基于大数据进行预测的准确性如何,对大数据的依赖是否会导致道德或者公平性问题。

其实,早在2014年5月,美国白宫就发布了《大数据:抓住机遇,保存价值》中呼吁重视自动化决策中的歧视问题,要求民权和消费者保护机构及FTC等政府机构加强专业知识,调查并解决潜在的歧视问题。

对人工智能进行法律政策保护的思考

1、知识产权保护方面

国内企业应该利用既有专利规则、版权规则、职务发明等知识产权规则,强化对AI的全方位知识产权保护。

版权保护方面:国际标准化组织IEEE在其标准文件草案中提出的版权保护基本原则,目前也为国内现行法律认可,即如果AI依靠人类的交互而实现新内容或者发明创造,那么使用AI的人应作为作者或发明者,受到与未借助AI进行的创作和发明相同的知识产权保护。因此,相关AI的原代码产生后,应及时通过软件著作权登记等措施进行证据固化。

专利技术和商业秘密保护方面:AI开发过程中涉及到的专利技术,应当经过专业技术人员评估,如果可保密性强,被反向工程的可能性不大,则通过商业秘密进行保密而保护,如果被反向工程或者披露的可能性较大,则应当及时进行专利申请,以公开换取独占性保护。

商标保护方面:重点AI产品应及时进行产品名称和标志的商标申请和保护,使产品能够在市场上获得认知,扩大产品品牌影响力。

2、隐私和数据安全方面

在提供服务的过程中收集、使用用户个人信息,应当遵循合法、正当、必要的原则。不得收集与提供服务所必需以外的用户个人信息或者将信息用于提供服务之外的目的,不得以欺骗、误导或者强迫等方式收集、使用用户个人信息。比如,在图像识别、语音识别等领域,对于机器深度学习的原始素材、语料等的收集、分析、使用,需要事先经过用户的知情同意。

同时,积极履行信息安全保障义务。在对用户数据收集、使用过程中的用户个人信息应当严格保密,不得泄露、篡改或者毁损,不得出售或者非法向他人提供。对用户数据的输出和使用,应当做到匿名华、假名化,并做到脱密处理。

3、标准化建设方面

技术专利化、专利标准化、标准国际化。统一技术、数据使用、安全等标准化建设将会是未来人工智能技术标准化建设的主要趋势。因此,积极参与标准化讨论和提案,在“技术专利化,专利标准化,标准国际化”方面做足功夫,努力将企业的技术专利加入标准中,并成为行业国际通用标准。

4、防歧视方面

如前所述,目前人工智能,在发展过程中可能由于技术不完善、算法不健全或算法不公开、不透明等原因,面临种族歧视、性别歧视等问题,并由此产生了很多负面效果。因此,对于中国企业来说,也应该提前思考,如何通过技术提高算法完善和算法公开化、透明化等措施,来避免类似问题的发生。

中国移动

中国移动 ROBAM老板

ROBAM老板 飞利浦

飞利浦 苏泊尔

苏泊尔 西门子

西门子 海尔

海尔 格力

格力 美的

美的 华北工控

华北工控 三星

三星 HTC Vive

HTC Vive 索尼

索尼 Oculus Rift

Oculus Rift 科大讯飞

科大讯飞 英特尔

英特尔 iPhone

iPhone IBM

IBM Facebook

Facebook 微软

微软 亚马逊

亚马逊 google谷歌

google谷歌 蚁视复眼

蚁视复眼 戴VR眼镜的

戴VR眼镜的 QMER V1

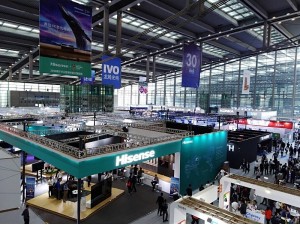

QMER V1 2018中国电博会 深圳市汇春科技股份有限公司

2018中国电博会 深圳市汇春科技股份有限公司 中国智能制造网带你直击2018第六届电博会

中国智能制造网带你直击2018第六届电博会 荣耀VR眼镜

荣耀VR眼镜 人工智能

人工智能 小8 VR自助体验机

小8 VR自助体验机